无需对抗样本训练即可提高模型鲁棒性的方法(JARN)

- 论文名称:《Jacobian Adversarially Regularized Networks For Robustness》

- 作者单位:Alvin Chan/ Nanyang Technological University

- 收录时间:2020 ICLR

- 文章亮点:提出了雅可比对抗正则化网络(JARN)方法,通过训练,优化模型输出的雅可比矩阵,同时提高模型的鲁棒性。这是一个不需要对抗样本实例进行对抗训练就可以提高模型鲁棒性的新角度。

Motivation

- 目前提高模型鲁棒性的最好防御措施基于对抗训练(AT),但是这个过程中生成所需要大量的对抗样本实例也带来不小的计算量。

- 之前的研究表明,经过对抗训练的鲁棒模型比非鲁棒模型更容易得到个更突出和解释性强的雅可比矩阵。

- 因此自然的想到一个问题:可否通过训练模型产生显著的雅可比矩阵以得到鲁棒性更好的模型呢?

- 文章是第一个发现这个问题,并给出肯定结论的文献。

Related Work

- Tsipras et al. (2018)观察到:高鲁棒性的对抗样本产生的显著雅可比矩阵与输入图像类似,而低鲁棒性的图像则表现为高噪声的雅可比矩阵。

- Etmann et al. (2019)指出:对抗样本与决策边界之间的距离随着雅可比矩阵和输入图像间的校准。

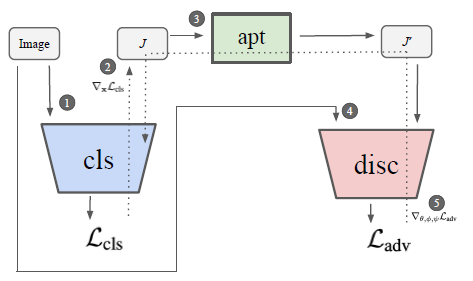

Jacobian Adversarially Regularized Networks(JARN)

- 利用生成对抗网络(GANS):构建一个分类器作为生成器模型,使得Jacobian逐渐欺骗鉴别器模型将其解释为输入图像。

- 由于雅可比矩阵和输入图像在像素值分布上并不匹配,若不加以调整,GANs中的鉴别器可以轻松通过这显著的区别加以区分,因此需要引入一个映射,将雅可比矩阵映射到输入图像的域中。

JARN算法训练结构

- 首先计算分类的交叉熵

- 计算雅可比矩阵

- 将雅可比映射到图像域

- 计算对抗损失

- 更新以最小化分类器和鉴别器的损失

JARN算法训练结构

Experiments

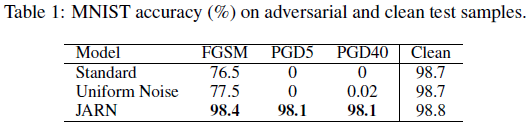

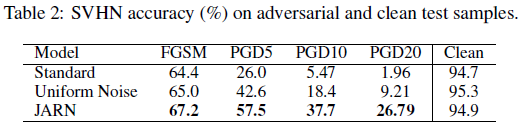

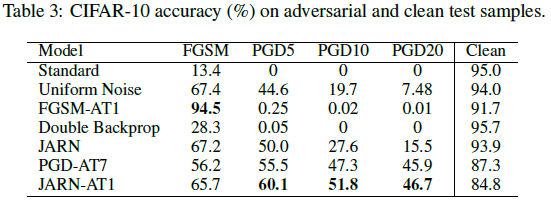

数据集:MNIST, SVHN and CIFAR-10

攻击方法:FGSM、PGD5、PGD40

实验结果:JARN在三个数据集中均表现出优于baseline的性能

MNIST实验结果

SVHN实验结果

CIFAR10实验结果

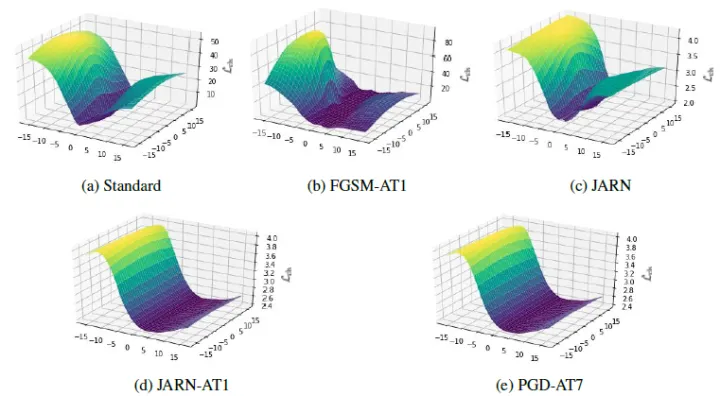

观察Loss Landscape:沿着对抗性扰动的方向和随机正交方向计算计算分类损失值。由图中我们可以看出,Standard和FGSM-AT都具有锯齿状和非线性的损耗曲面。这就解释了为什么利用FGSM对FGASM-AT训练后的模型进行多次迭代攻击失败的原因:模糊梯度。观察图三中的c、d、e三幅图,我们可以知道:JARN-AT1的对抗鲁棒性并不是由于模糊梯度造成的。

Loss Landscape

增加雅可比可以显著提升鲁棒性的一种可能解释:在JARN使得雅可比空间在正则化下收缩了,即雅可比空间必须类似于非噪声图像。意味着对抗样本在Loss Landscape中达到最优的路径会更少,因此提高了模型的鲁棒性。

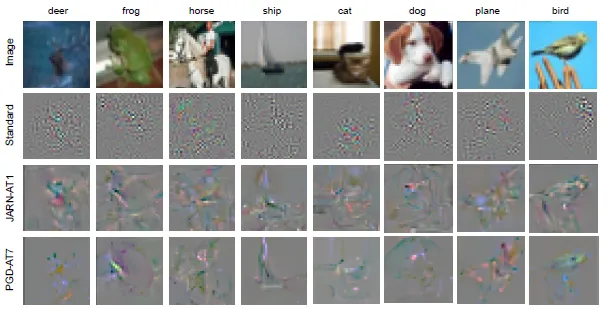

雅可比图像:与标准模型相比,JARN和PGD-AT的雅可比矩阵更加突出,在视觉效果上更接近原图。

雅可比图像

Enjoy Reading This Article?

Here are some more articles you might like to read next: