提出了矩形遮挡攻击,提高模型对可物理实现的攻击的鲁棒性

- 论文名称:《Defending Against Physically Realizable Attacks On Image Classification》

- 作者单位:Tong Wu、Liang Tong / Washington University in St. Louis

- 收录时间:2020 ICLR

- 文章亮点:提出了矩形遮挡攻击,利用生成的矩形对抗样本进行对抗训练,训练出来后的模型表现出对可物理实现的攻击表现出很高的鲁棒性。

Motivation/Problems

前人针对神经网络的三种物理攻击

- (Sharif et al.,2016)设计的对抗性眼睛框欺骗人脸识别模型。

- (Eykholt et al., 2018)通过贴贴纸欺骗停车信号的识别。

- (Brown et al., 2018)普遍适用的对抗性样本补丁,导致任何目标错误分类。

存在问题

目前很多防御方法集中在数字图像层面,但是还没有专门有效的方法来防御可物理实现的攻击。

文章成果

- 将“对抗训练”和“随机平滑”这两种防御方法在对抗物理攻击进行有效性评估。证明了:在真实物理对抗样本的情况下,上述两种传统的防御方法很大程度上无效。

- 提出了一种新型的物理对抗样本模型——矩阵遮挡攻击,并利用对抗训练去训练网络的鲁棒性。并用实例证明了本文提出的方法比“对抗训练”和“随机平滑”这两种防御方法在对抗物理攻击时,更加有效。

Proposed Approach

-

文章提出了Defense Against Occlusion Attacks(DOA)一种抵御遮挡攻击的防御方法。

-

文章同时提出了Rectangular Occlusion Attacks(ROA)一种矩形遮挡攻击方法

攻击者引入固定尺寸的矩形,摆放在任意位置,在区域位置内允许添加任意噪声。

ROA攻击优点:由于只限制了一个固定区域,因此该攻击比$L_{\infty}$攻击更容易计算。

具体的ROA攻击方法执行步骤是:

-

首先使用灰色矩形执行穷举搜索以找到最大损失的位置

-

然后确定位置并在矩形内应用PGD攻击算法

-

Experiment

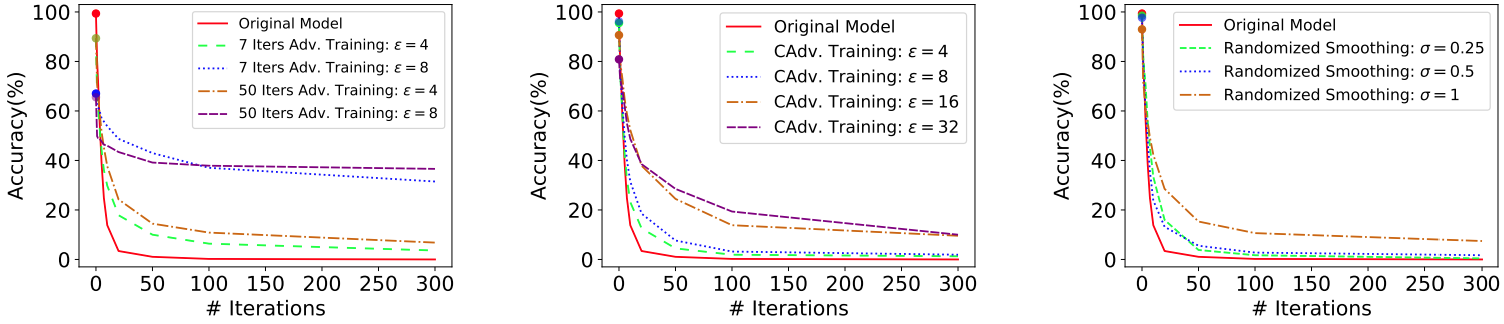

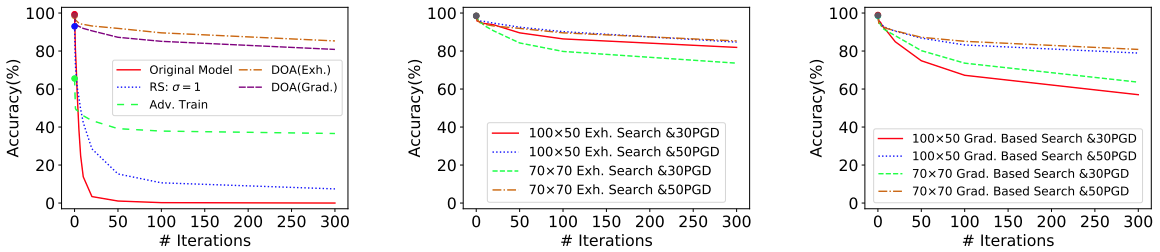

传统的鲁棒机器学习方法能否有效应对显示物理攻击?

- 实验对象

- adversarial training (by a-la-Madry et al.)

- curriculum adversarial training(by Cai et al.)

- 传统的randomized smoothing 方法。

-

实验参数

对抗实例的生成利用PGD攻击方法来生成,并通过改变ϵ∈{4,6,16,32}和迭代次数从7~50变化。观察攻击样本的正确率。

-

实验场景

人脸欺诈场景和停车信号欺诈场景

- 实验结果

人脸欺诈场景实验结果

停车信号欺诈场景实验结果

- 实验结论

传统的鲁棒机器学习方法在抵御物理攻击方面表现不佳有以下两点原因:

- $L_p$扰动对于对抗模型来说难以进行有效的鲁棒学习

- 传统的攻击模型对与现实的物理攻击来说太不匹配

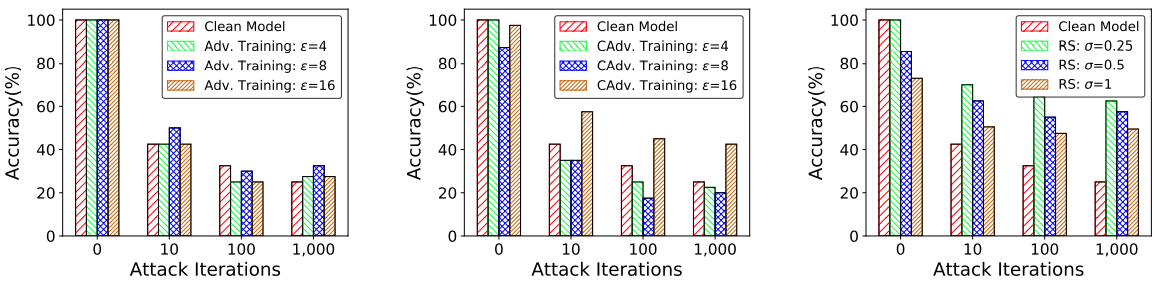

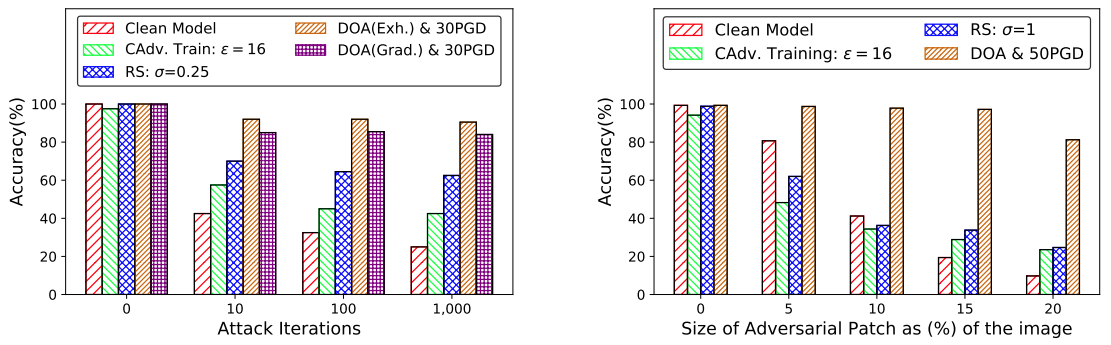

DOA 物理攻击防御方法有效性验证

DOA人脸欺诈场景

DOA停车信号欺诈场景

实验证明了,利用ROA算法所提出的DOA防御算法在面都物理攻击时确实比传统的方法表现出很好的鲁棒性

Enjoy Reading This Article?

Here are some more articles you might like to read next: