首个无需真实数据的黑盒攻击模型

- 论文名称:《DaST: Data-free Substitute Training for Adversarial Attacks》

- 作者单位:电子科技大学、旷视科技成都研究院

- 收录时间:2020 CVPR

- 文章亮点:首个无需真实数据的黑盒攻击模型

Motivation:

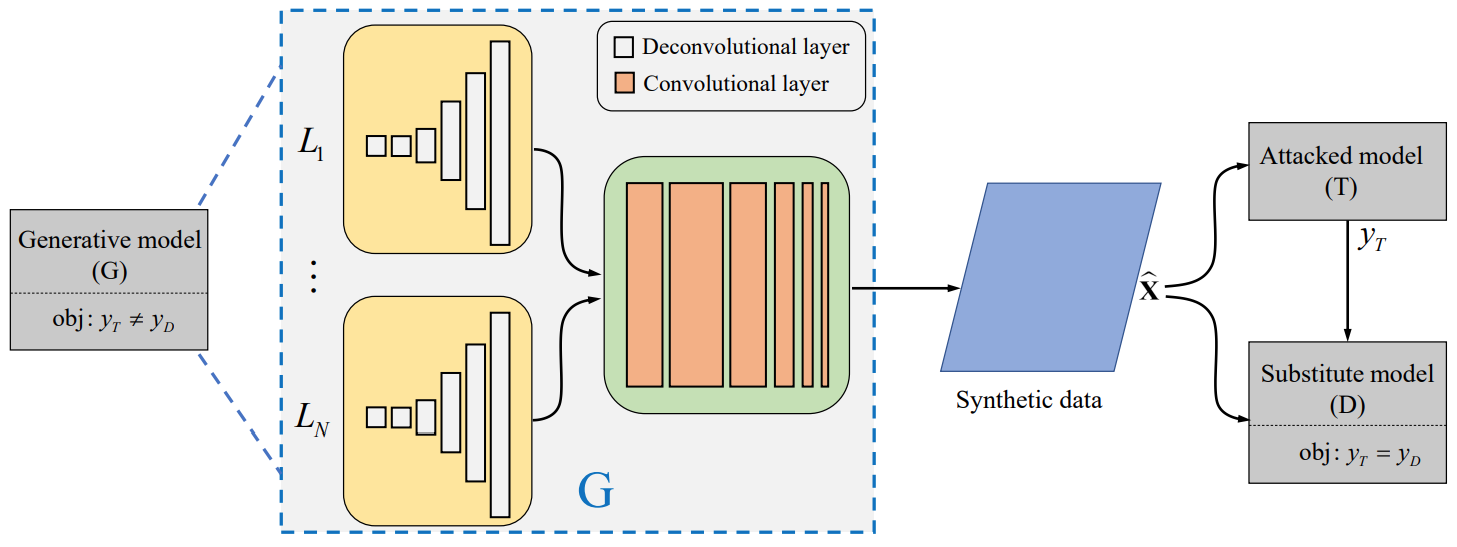

文章利用对抗生成网络(GANs)生成的合成样本去训练替身模型,然而传统的GAN在没有真实数据的情况下,生成的样本分布可能及其不均,且只包含一部分类别,这意味着替身模型将不能充分的学习到目标模型的分类特性。因此文章为生成模型设计了一个多分支架构和一个控制标签的损失函数,以解决合成样本分布不均的问题。

无需真实的数据,即可以生成攻击效果不错的对抗样本,在真实数据很难获取的现实情况中,此方法更具有其独特的价值。

存在问题

- 在现实生活中,黑盒攻击比白盒攻击更为实用,但是难度更大。

- score-based attacks和 decision-based attacks 攻击是直接使用分类概率或目标模型返回的标签。这种方法虽然不需要模型,但是需要大量的查询。

- gradient-based attacks需要了解目标模型的架构和权重。

- substitute attacks不需要大量的查询,但是需要很多目标模型的真实数据来训练替身模型。

Method

-

攻击场景 只知道标签的场景(Label-only scenario) 只知道概率的场景(Probability-only scenario)

- 对抗攻击

- 对于白盒攻击来说,它需要完全获取目标模型的梯度信息,接着用其生成对抗样本攻击目标模型。

-

对于黑盒攻击,训练一个目标模型的替身模型以生成对抗样本,并迁移样本以攻击目标模型。

-

黑盒攻击的成功率严重依赖于对抗样本的可迁移性,因此,替身攻击的关键点在于训练一个替身模型,它的属性尽可能和目标模型相似。

-

当前的攻击方法一般利用和目标模型相同的训练集,或者收集目标模型的标注的大量其他图像以训练替身模型。

-

对抗性生成器和分类器训练

生成器:在输入空间中随机生成噪声,并合成数据。将合成数据输入到目标模型中得到输出数据。

分类器:将生成器获得的合成数据和输出数据作为替身模型的训练参数。

通过以上的不断训练,使得替身模型越来越趋近于目标模型。因此利用替身模型得到的生成对抗样本对目标模型将会很好的迁移性。

Experiment

-

Dataset

MNIST、CIFAR-10、Microsoft Azure

-

实验说明

本文提出的DaST方法,在无需真实数据的情况下,可以在上述的数据中进行表现良好的攻击。

-

存在缺陷

由于GAN对抗生成网络存在合成样本不均匀的特点,为了解决这个问题,要解决这个问题,算法需要在gradient-based方法的基础上进行改进。该方法需要了解模型的参数和架构。

Enjoy Reading This Article?

Here are some more articles you might like to read next: